百度搞了一个数据集开源计划 Baidu Research Open-Access Dataset (BROAD),其网址为 Baidu Research Open-Access Dataset,其中有一个数据集 称为 Video Highlights 。

任务描述

该数据集(下文中简称为BROAD-VH数据集)在介绍中将其定义为视频精彩片段提取任务。具体而言,就是提取视频中可能包含精彩片段的时间区域,而不需要对精彩片段的类别进行分类。

视频及数据信息

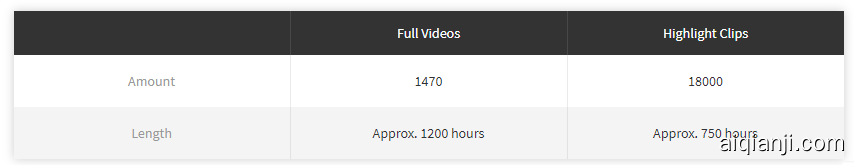

BROAD-VH数据集主要来源于爱奇艺视频。视频类型为综艺节目,目前包括1500个长视频,视频总时长约1200小时。该数据集的视频时长分布图如下图所示(长度单位为帧)。按照总帧数和总时长的比例,估计采样的fps大概为1.5吧,算是比较低的采样频率了。

训练/验证/测试集的视频数量划分如下

标签信息及分布

该数据集中一共有18000个精彩片段的时序标注,平均一个视频有12个时序标注。这些精彩片段的总时长占1500个小时中的750个小时,即有一半左右的视频时长被标注为了精彩片段。

对训练集的标签信息进行了分析,分析的主要内容为精彩片段时长的分布,分布直方图如下图所示。

可以看出,大部分精彩片段的长度都在30-300帧的范围。

测评方式

测评方式部分与通常temporal action proposal任务中不同,并没有使用average recall (平均召回率),而是同detection任务一样使用了mAP,此处将所有highlights片段都看作为了一个动作类别。比较有趣的是,BROAD-VH基本上直接使用了ActivityNet Challenge的detection任务测评代码(略有改动)。

简要分析

根据上面的介绍以及分析内容,可以对这个数据集进行一些简单的评价:

- 单个视频的时长可能很长(小时级别),单个视频中包含的精彩片段也比较多,这点与THUMOS数据集很像,而与单个视频时长短且包含片段少的ActivityNet数据集差异大

- 数据集标注的格式,测评代码等方面应该是直接参考的ActivityNet 数据集做的

- 数据的规模还是比较大的,从时长方面看比ActivityNet要长(ActivityNet时长大约为700小时)

- 视频的来源均为综艺视频,这点表明这个数据集的来源多样性比较单一

- 提供特征,其目的应该是节省研究者的计算开销。估计1500小时的视频,提取一遍特需要很长的时间。。根本没法玩。所以有现成的特征挺不错的。

meta file示例

{

"version": "VERSION 1.0",

"database":

{

"164161500": // Video id

{

"subset": "training", // Application,like training,validation, testing

"url": "", // Video’s playback link on iQiyi (Best online video site of China)

"annotations": [ // annotations

{

"segment": [10, 111],

// The begin time and end time of this segment. It’s eventually the index of the first dimension of feature.

},

{

"segment": [200, 527],

}

]

}

}

}

简单的尝试

用activitynet challenge 2017 proposal task中的baseline:uniform random 方法 activitynet/proposals

在视频随机的位置产生随机长度的proposals,并给予随机的confidence score。

在验证集中,对于每个视频生成了200个proposals,得到的mAP大概在0.027 左右。

(测评数据来自网络)

数据大小