LLaMA 大模型微调🚀

最近由于一些学习工作上的原因,我又捡起了大模型微调的这一项工作。由于微调大模型需要一个有 GPU 的 Linux 系统的电脑。实验室虽然有,但是这中操作怕电脑经不起折腾,还是根据其他人的方案在 AutoDL 上租一个实例来操作,整个过程也是比较复杂如果没有一些专业背景的话还是比较难做这个工作,低成本的训练效果一般很难达到应用标准,既然都做一遍了就把流程记录下来吧。

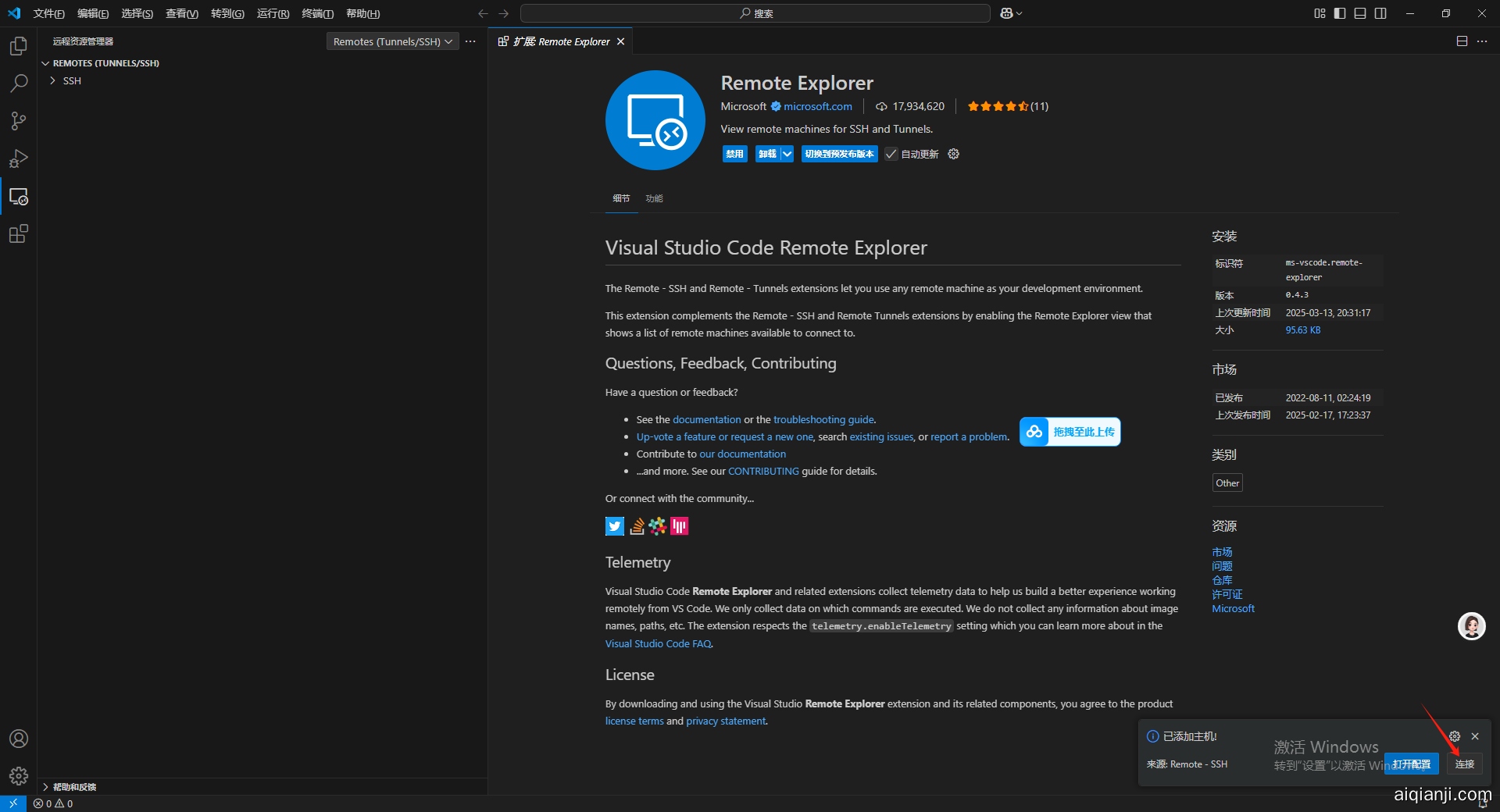

1.安装 Visual Studio Code 并安装 Remote Explorer 插件

为了方便开发,这里我们选择使用 Visual Studio Code 来远程访问 AutoDL 服务器进行开发,官方如下,工具也是免费的,下载完自己安装就可以了。

在安装完成之后需要在扩展里搜索 Remote Explorer 插件进行安装用于远程链接 AutoDL 服务器。

在安装完成之后左侧菜单栏扩展选项的上面会出现一个新的图标。

2. 租用 AutoDL 实例

之后在 AutoDL 上租一个 Linux 的带 GPU 的现成的服务器,当然需要首先充值一点点,进入页面后点击算力市场。

AutoDL 网址:https://www.autodl.com/home

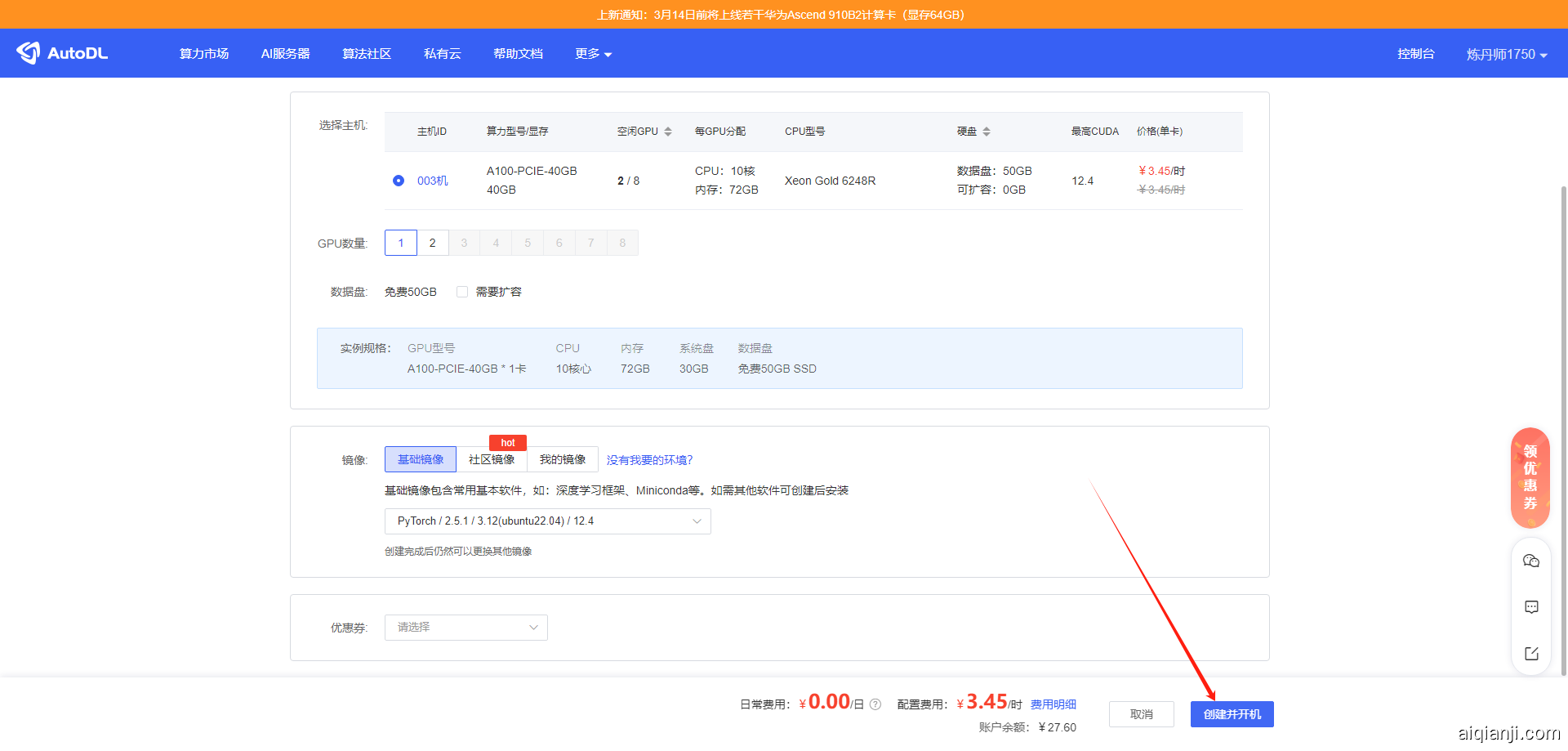

找一个能租的显卡,随便找一个就行,主要是熟悉一下完整的流程。

点进去之后在镜像部分选 PyTorch 的镜像,版本最新的就可以,对后续操作影响不大。

选好了之后点创建并开机。

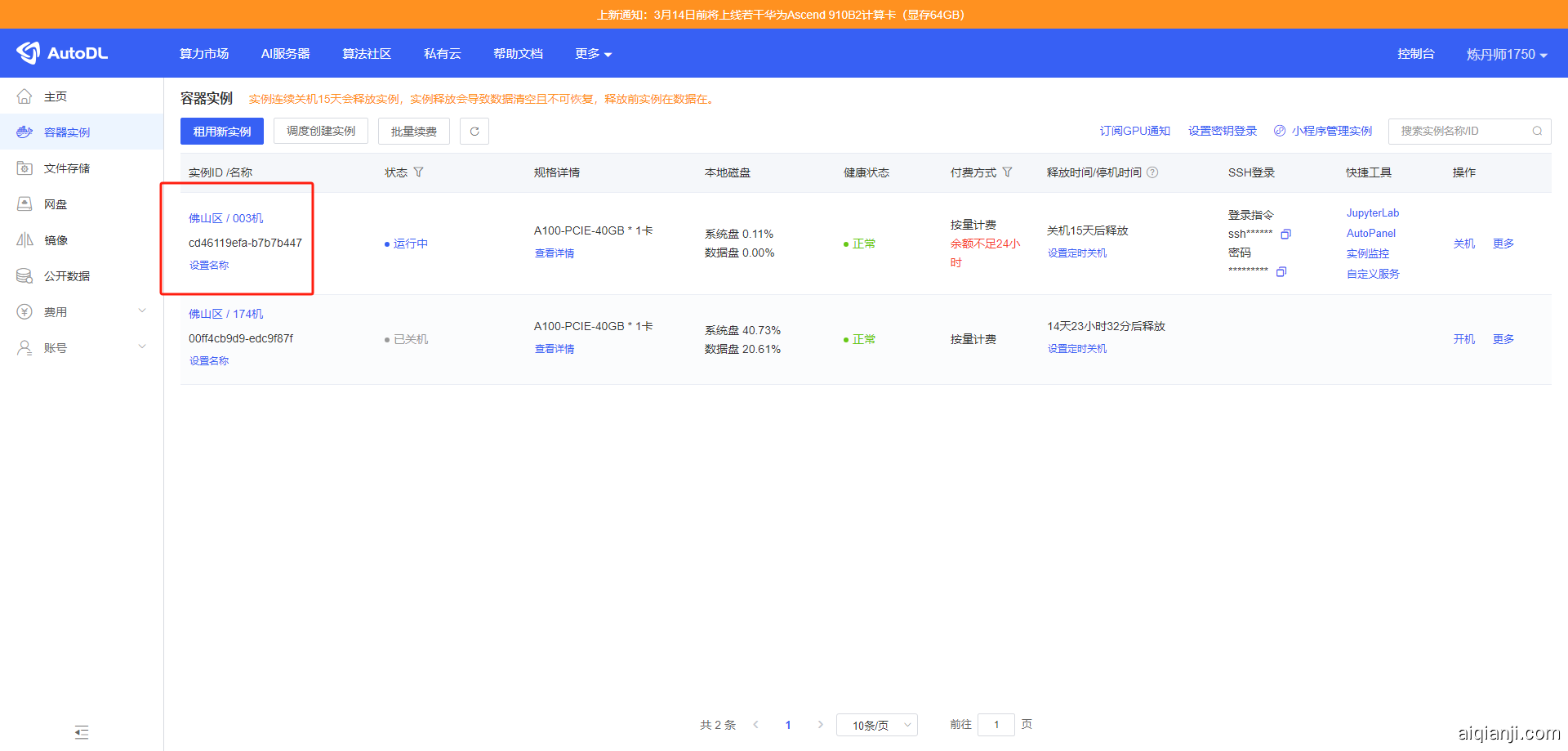

之后就会进入到这个页面。

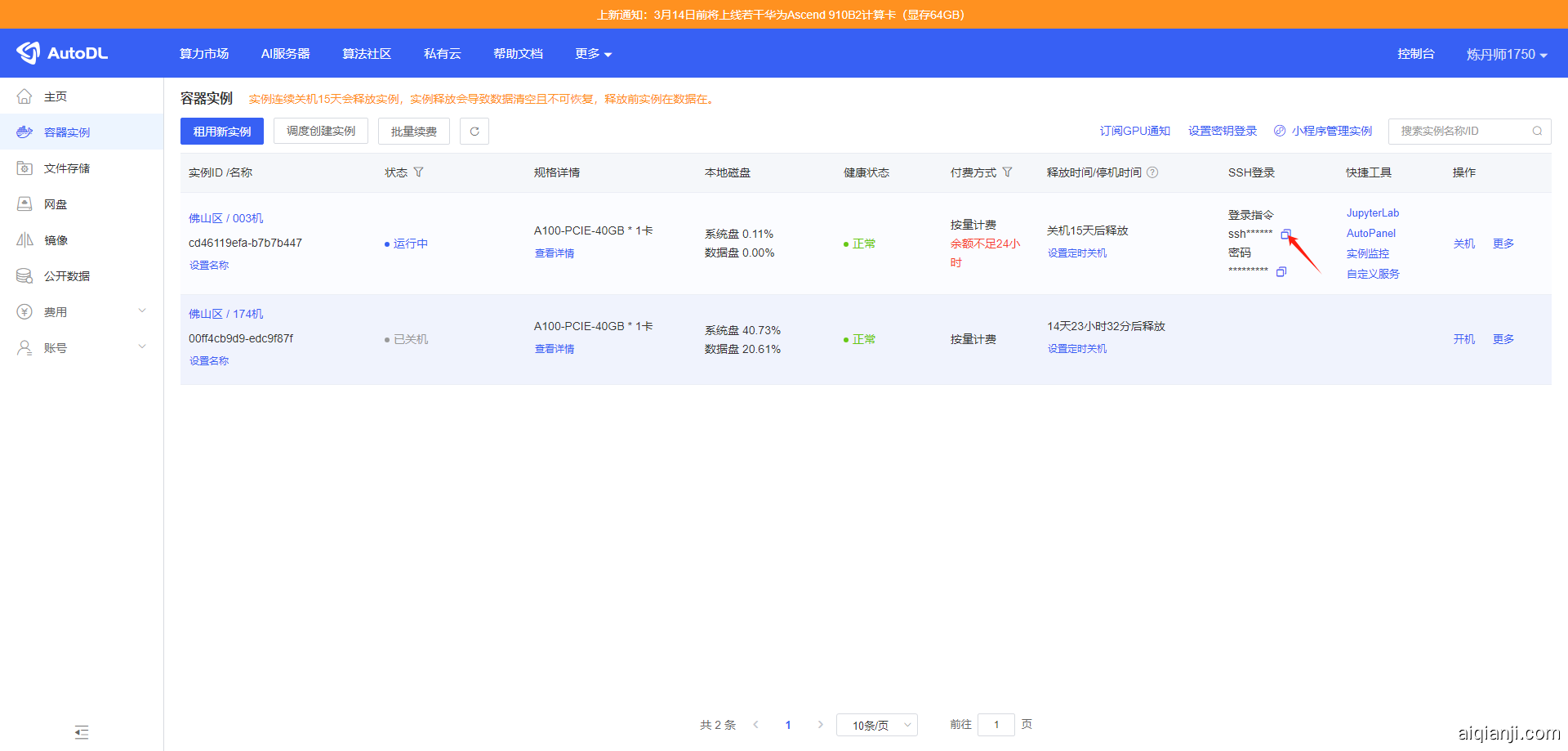

之后点击这个实例的 登录指令下方的 图标复制 SSH 登录命令备用,之后我们移步 Visual Studio。

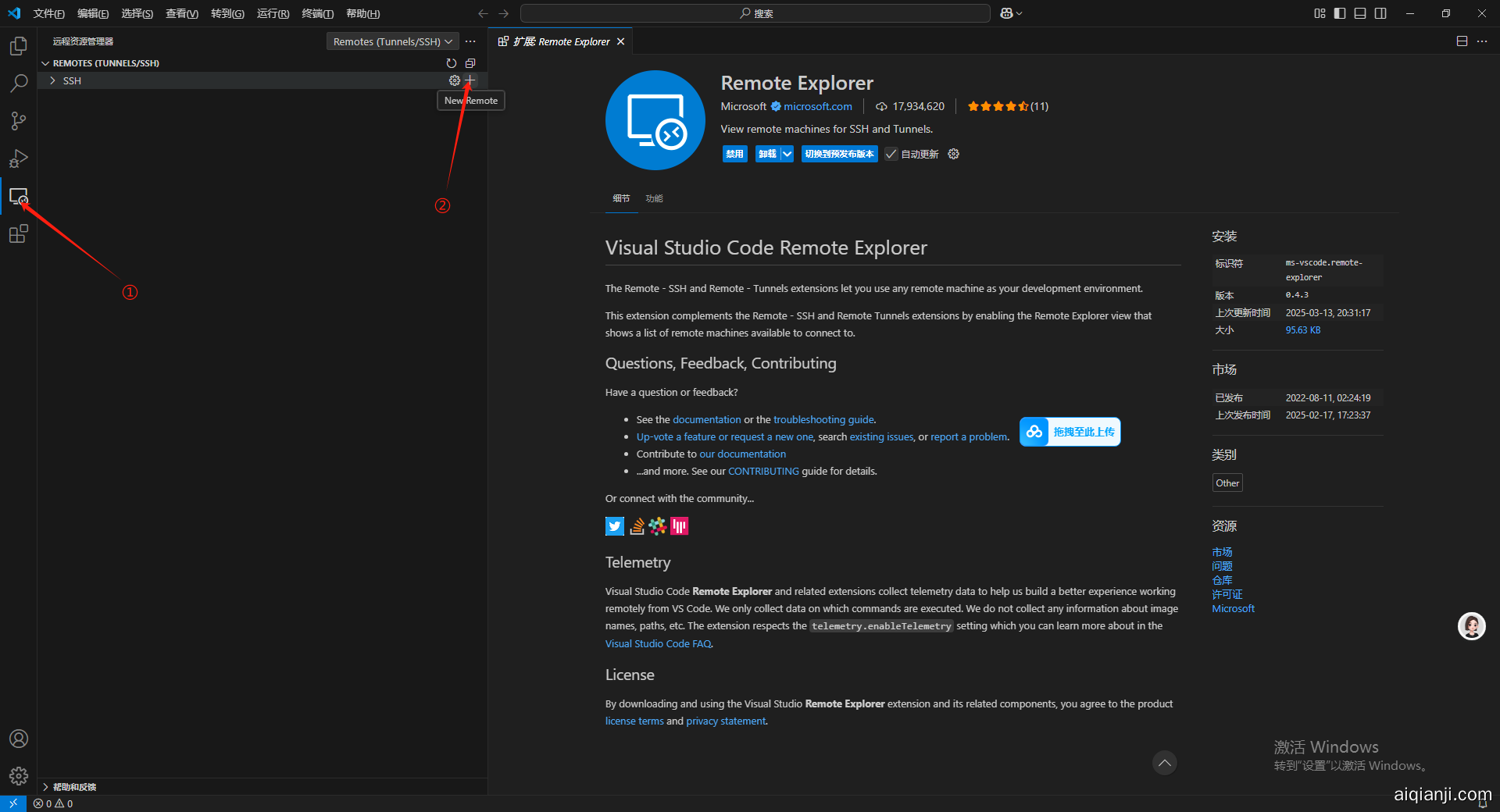

3.使用 Visual Studio Code 远程链接 AutoDL 服务器

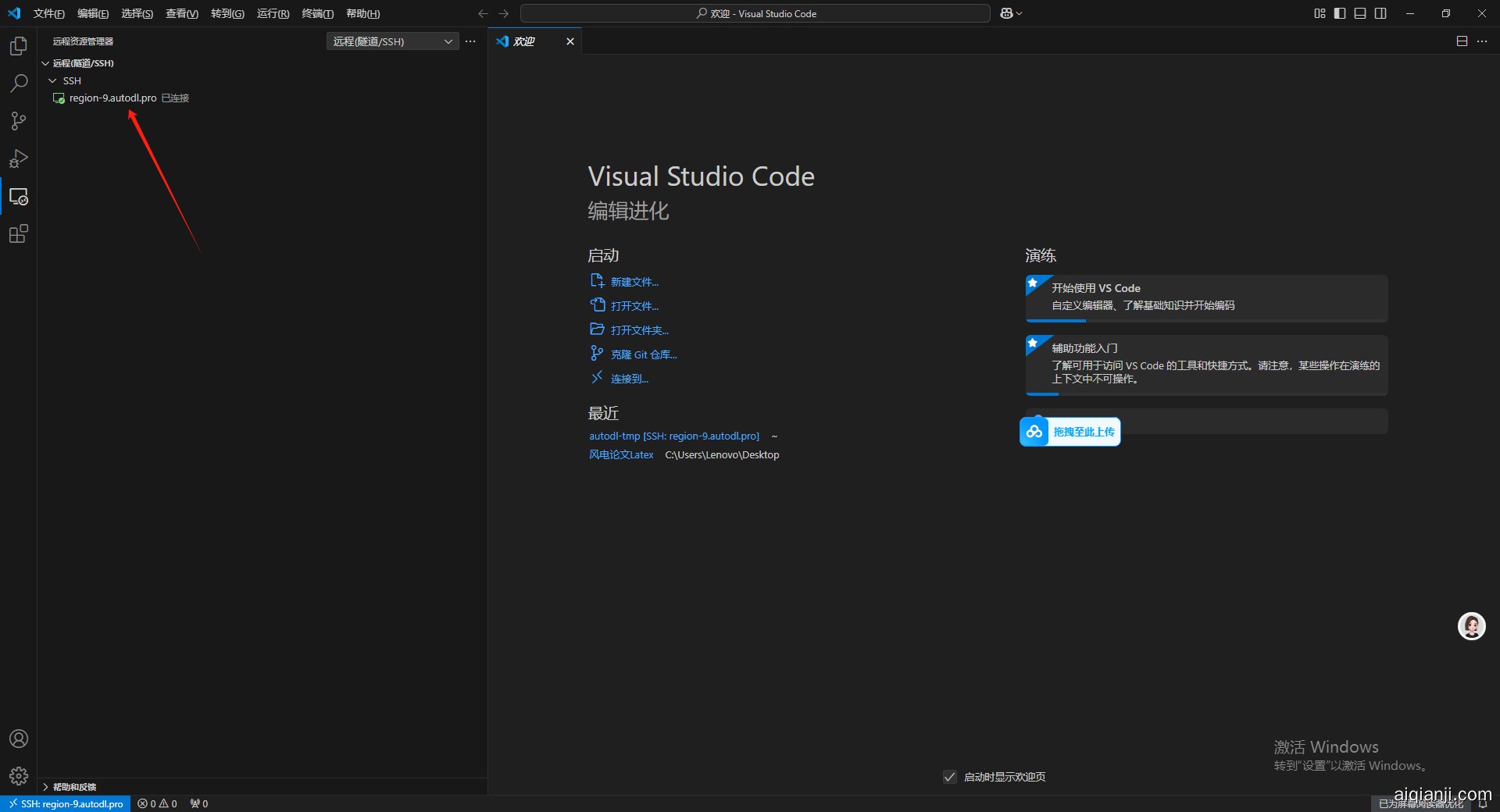

重新回到 Visual Studio Code 点击左侧菜单栏中的 Remote Explorer 图标,在弹出的菜单栏中点击 SSH 所在行尾部的加号(这里鼠标移动到对应位置才能看到加号)

把刚才用 AutoDL 中复制的 SSH 远程链接命令复制进去,然后按回车。

之后会出现要选择更新的 SSH 配置文件的选项,选择第一个点击即可。

点击链接。

出现一个新弹窗要求输入密码。

回到 AutoDL 界面,点击复制密码。

输入之后按回车。

等待远程链接完成。

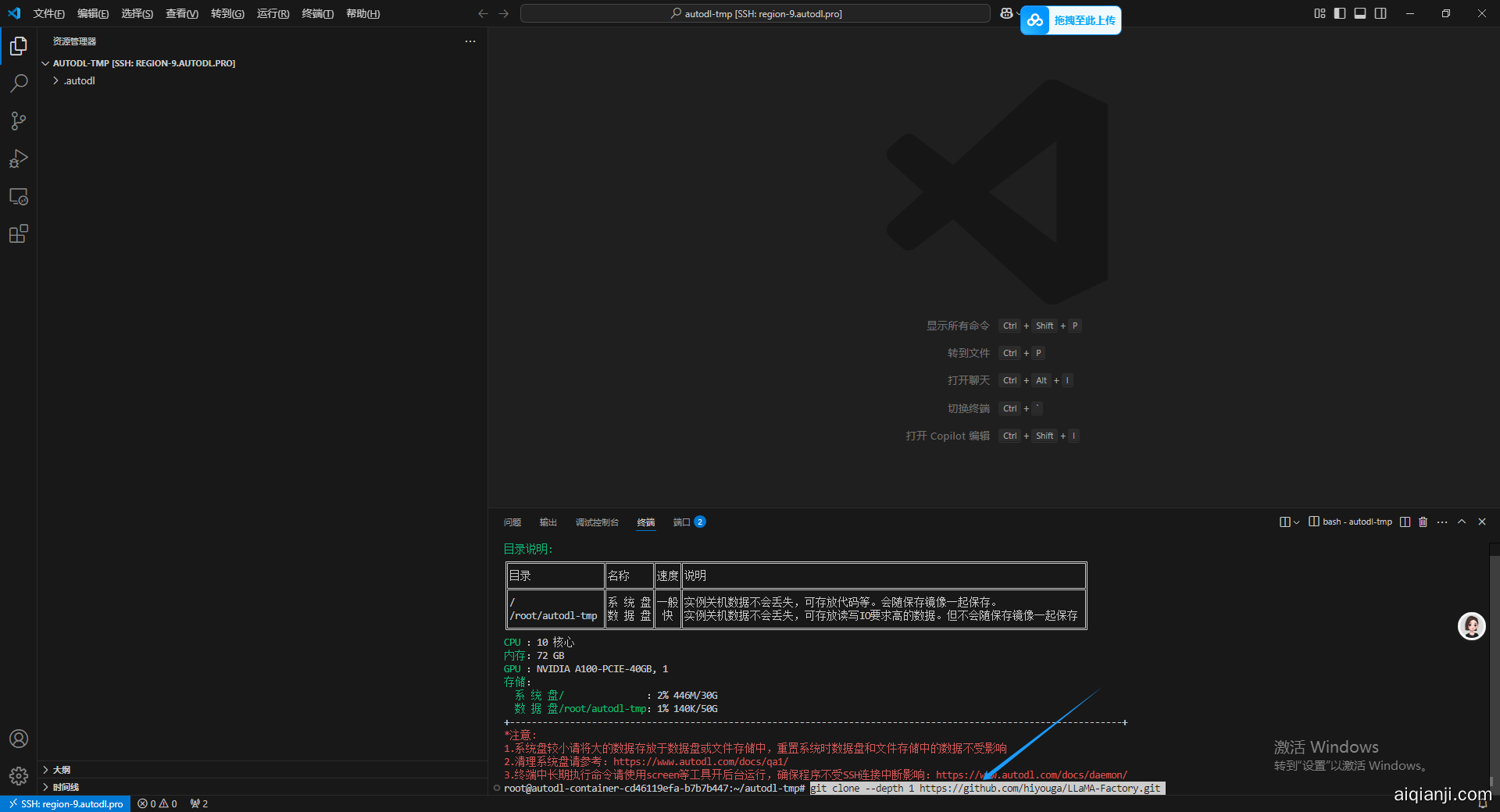

之后点击右上角的切换面板,打开终端界面,可以看到输出内容已经出现 AutoDL 服务器的信息。

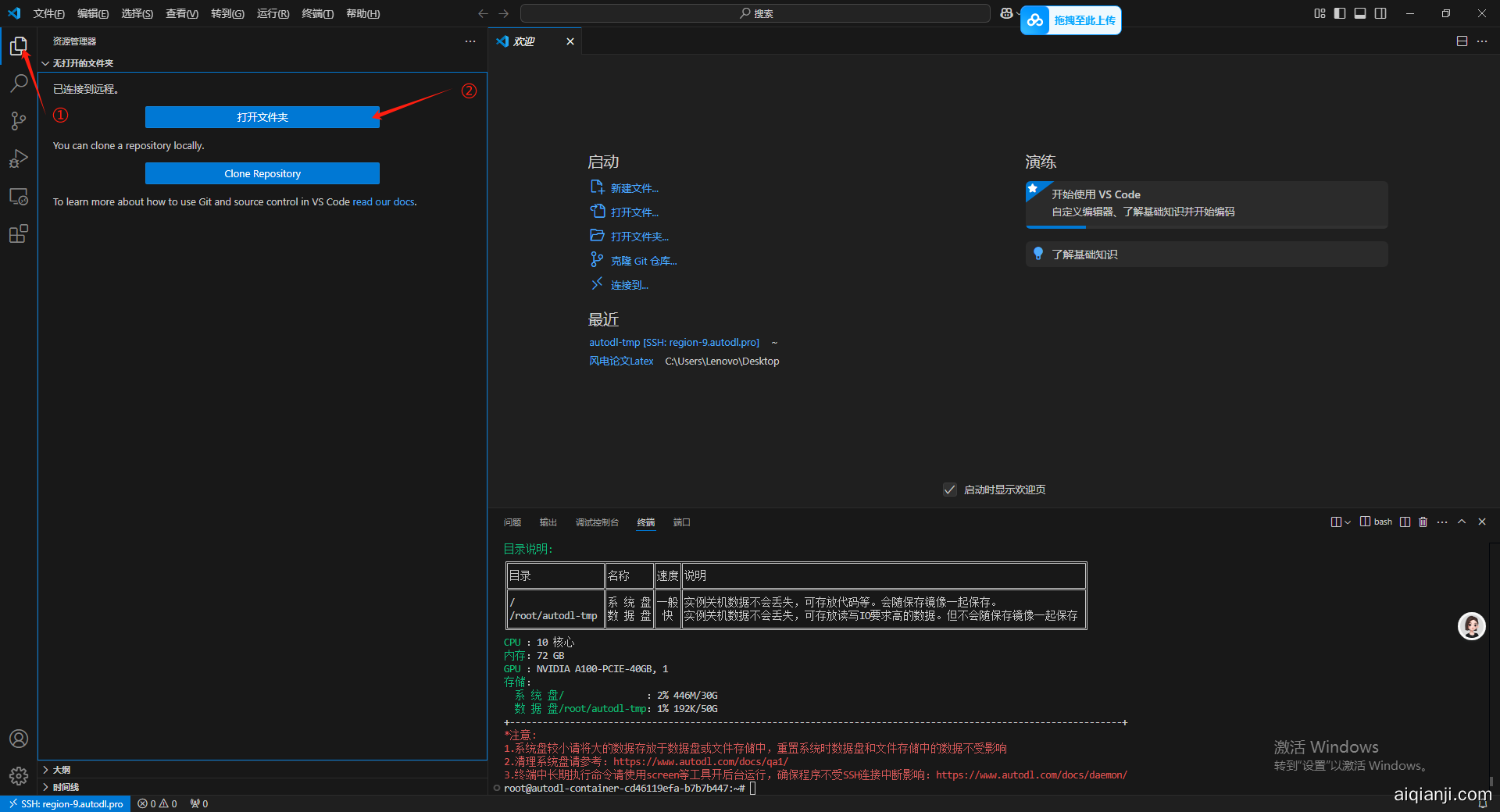

4.进入 autodl-tmp 数据盘

在远程链接了之后我们看不到远程链接的文件夹目录,因此我们要进入到对应的目录文件夹下,这里我们进入到 autodl-tmp 数据盘,主要在数据盘内进行操作,因为如果后续由于 AutoDL 的 GPU 算力不足的时候,可以直接克隆实例把我们的东西都克隆走。

然后这里提示还要输入一遍密码。

此时已经进入到 autodl-tmp 数据盘下面了。

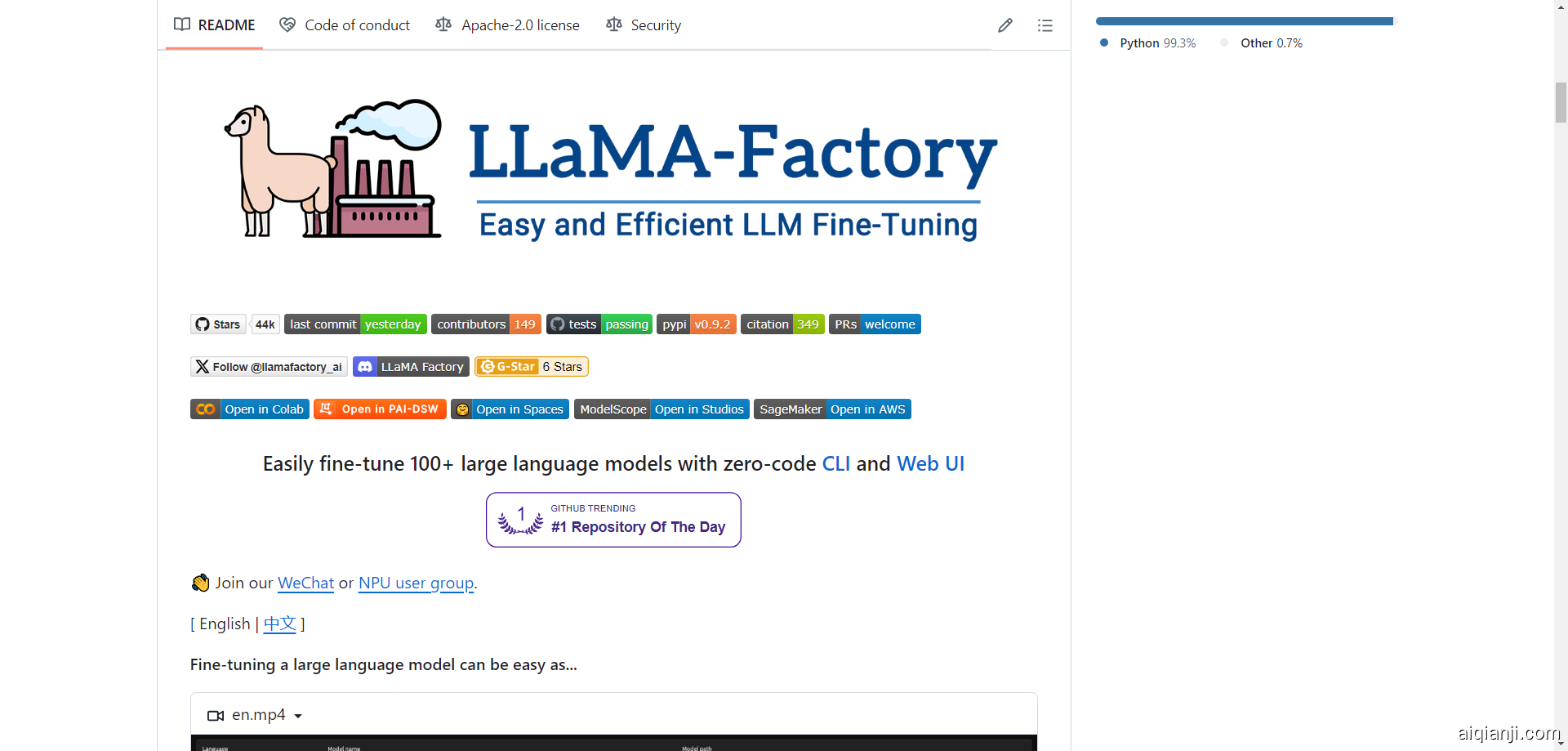

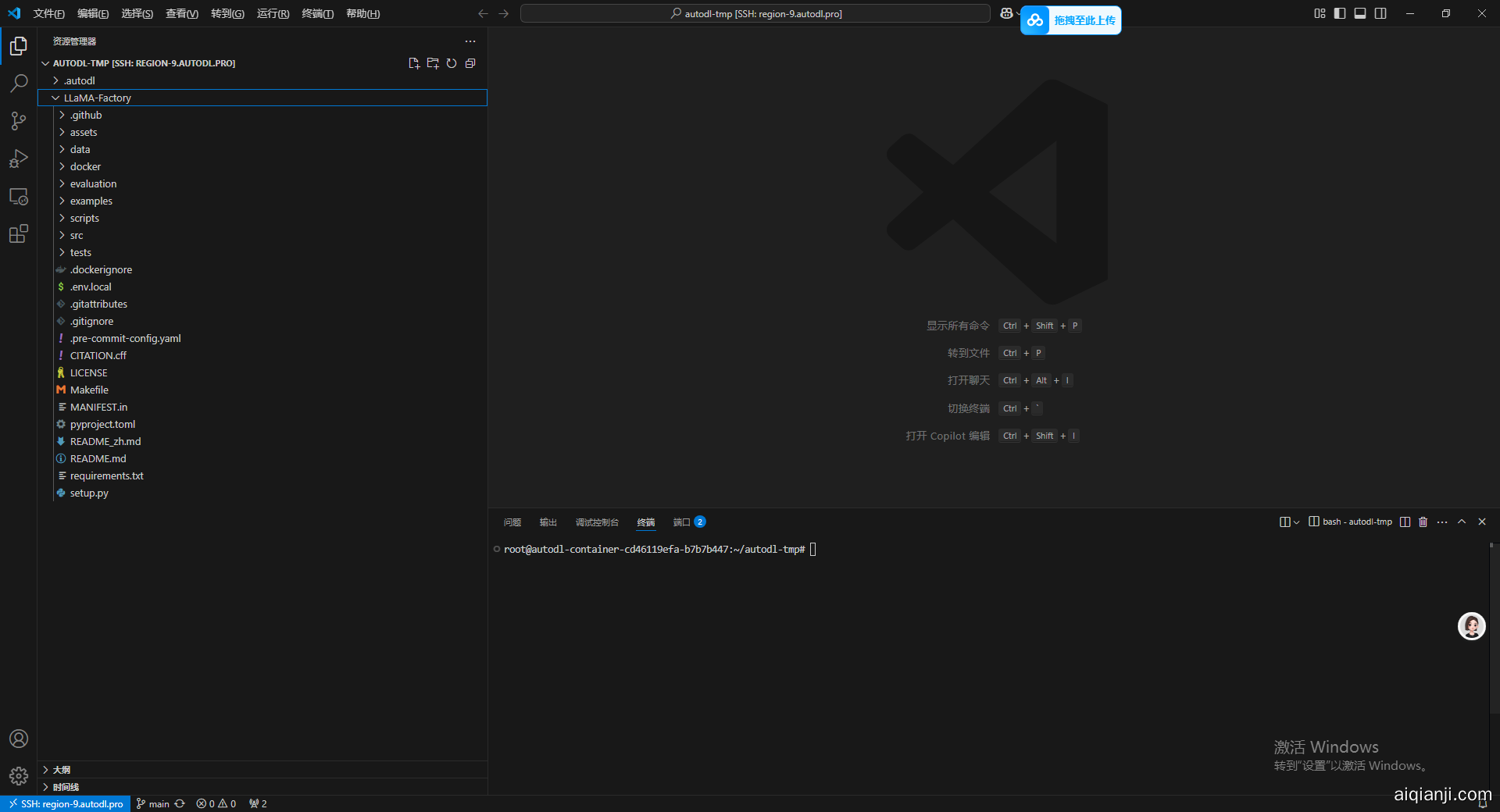

5.克隆 LLaMA-Factory

进入 LLaMA-Factory 官网 https://github.com/hiyouga/LLaMA-Factory

在 Code 里去复制他的 HTTPS 链接。然后在前面加上 Git clone -depth 1 构成一个克隆命令

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

然后在终端中输入克隆命令然后回车。

=如果报 HTTP2 网络错误 就先输入一下配置,使用 HTTP/1.1 然后设置大缓冲字节就可以。=

git config --global http.version HTTP/1.1

git config --global http.postBuffer 157286400

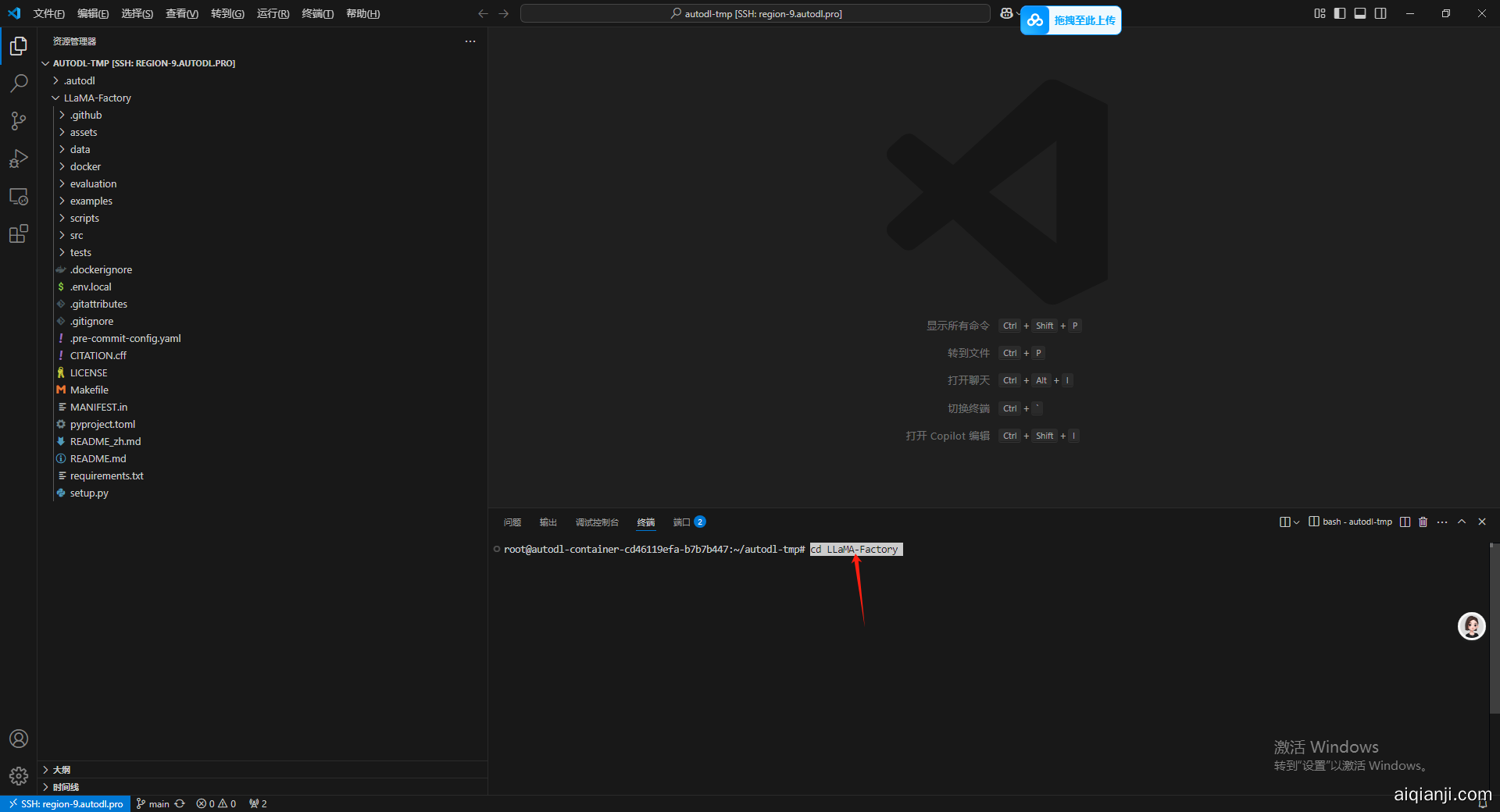

之后使用 cd 命令进入到 LLaMA-Factory 文件夹下,用于之后安装 LLaMA-Factory 的安装包

cd LLaMA-Factory

6.将 Conda 迁移到数据盘

这个主要的目的也是后续如果要对实例迁移的时候,可以把虚拟环境一并迁移过去。

mkdir -p /root/autodl-tmp/conda/pkgs

conda config --add pkgs_dirs /root/autodl-tmp/conda/pkgs

mkdir -p /root/autodl-tmp/conda/envs

conda config --add pkgs_dirs /root/autodl-tmp/conda/envs

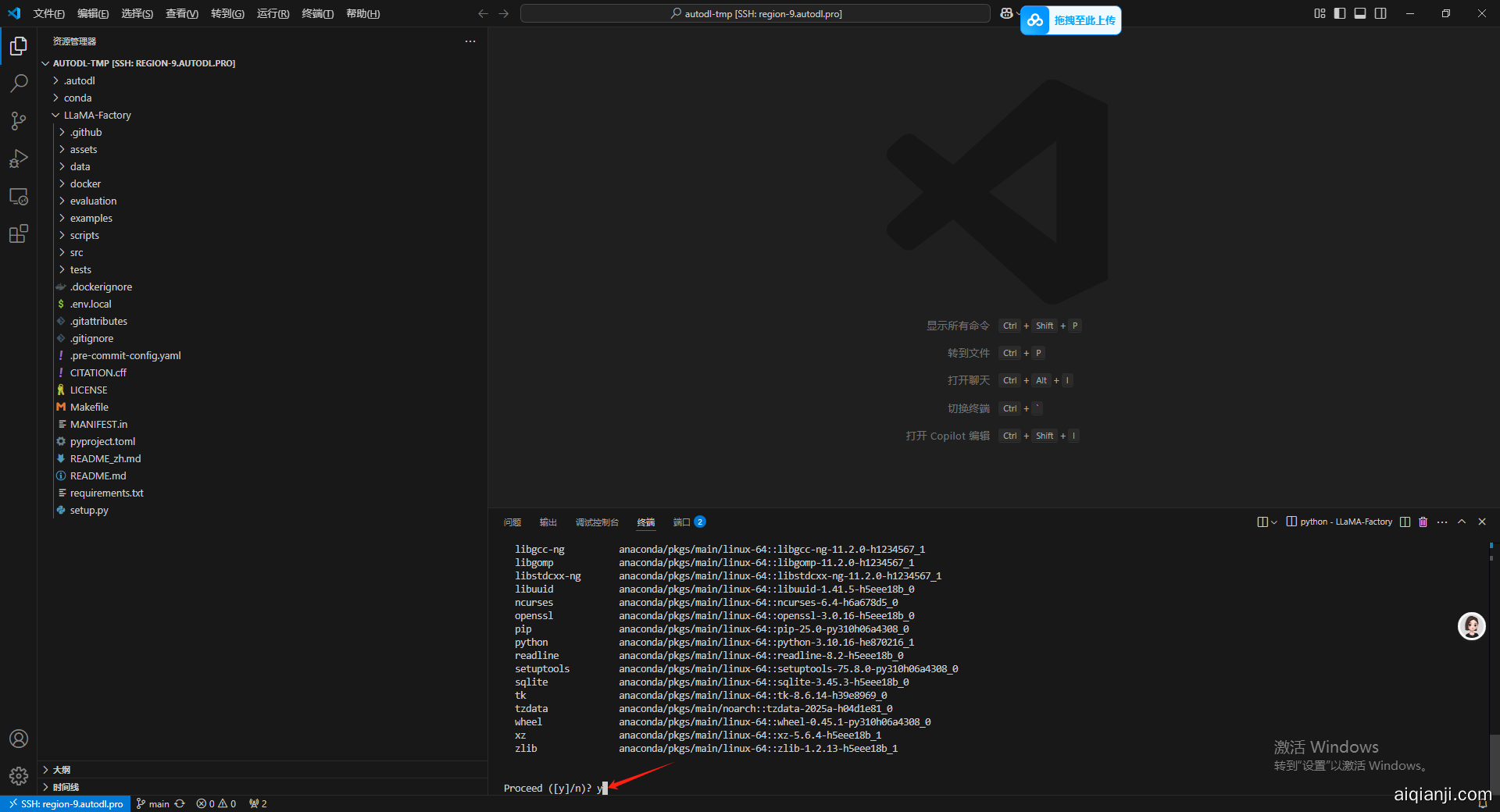

7.给 LLaMA-Factory 安装虚拟环境和依赖

运行之后在数据盘目录下会出现一个 conda 文件夹,之后按照官方的建议新建一个 python 版本为 3.10 的 conda 虚拟环境。

conda create -n llama-factory python=3.10

等待出现如下信息之后输入 y 然后回车,等待安装。

输入以下命令进入虚拟环境:

conda activate llama-factory

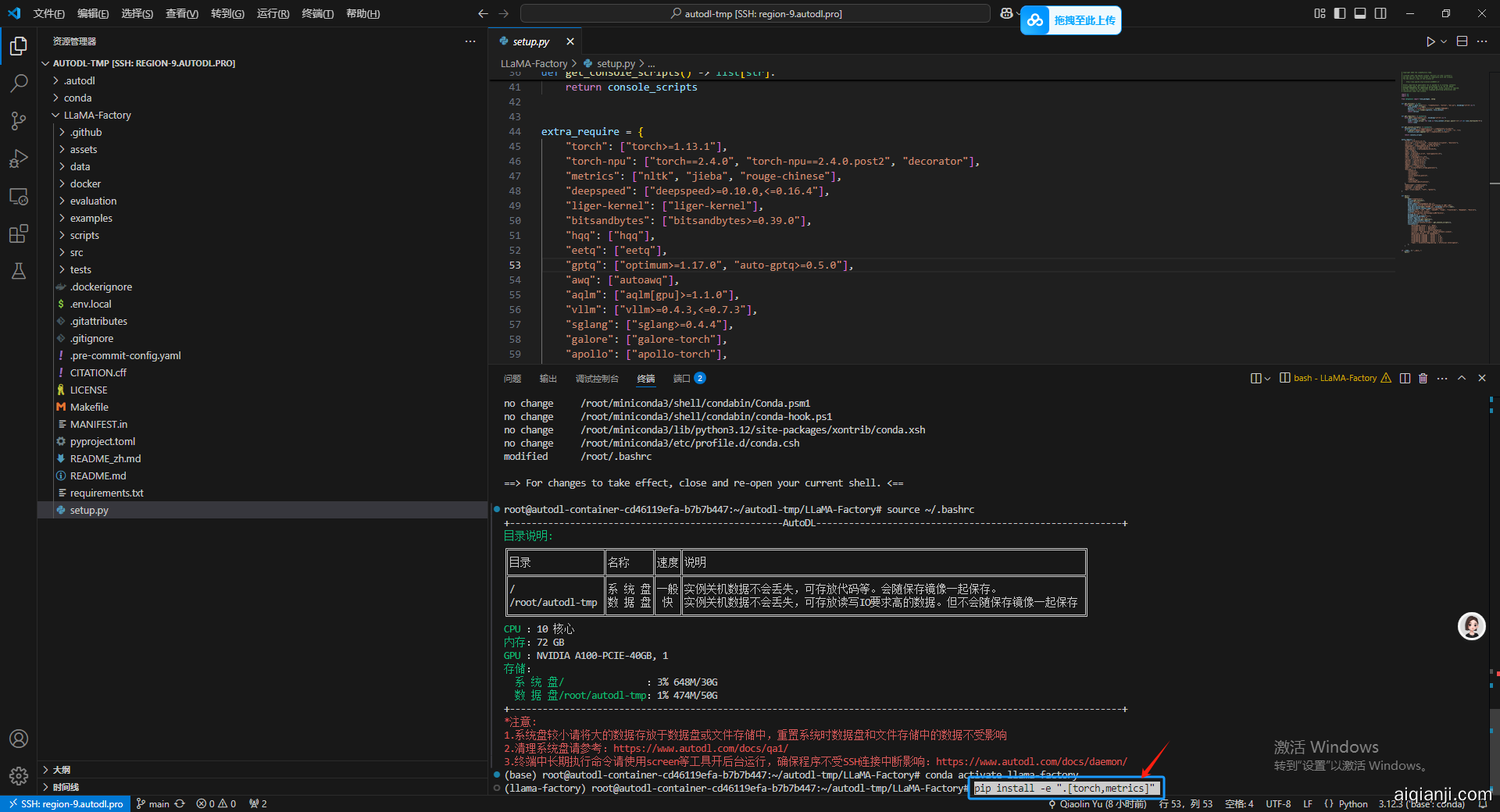

如果报错就输入 conda init 然后 再输入 source ~/.bashrc 刷新一下终端,通过命令行前面的括号内容就能看出已经成功进入当前虚拟环境了。

接下来,在当前虚拟环境下,安装相关的 python 依赖。

pip install -e ".[torch,metrics]"

等待安装成功。

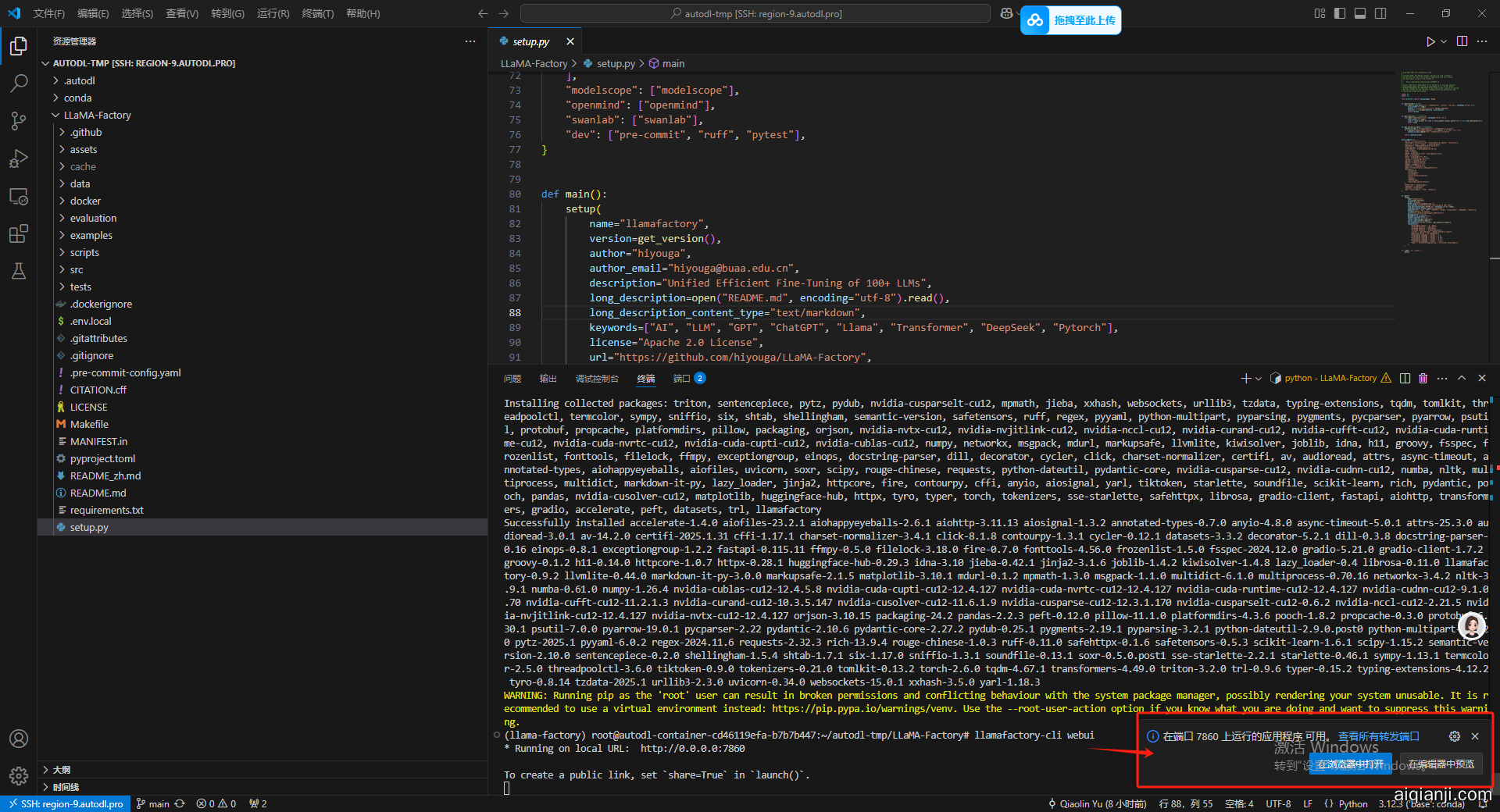

8.启动可视化微调界面

启动命令如下:

llamafactory-cli webui

进入到如下界面,代表我们的环境配置部分就成功了。

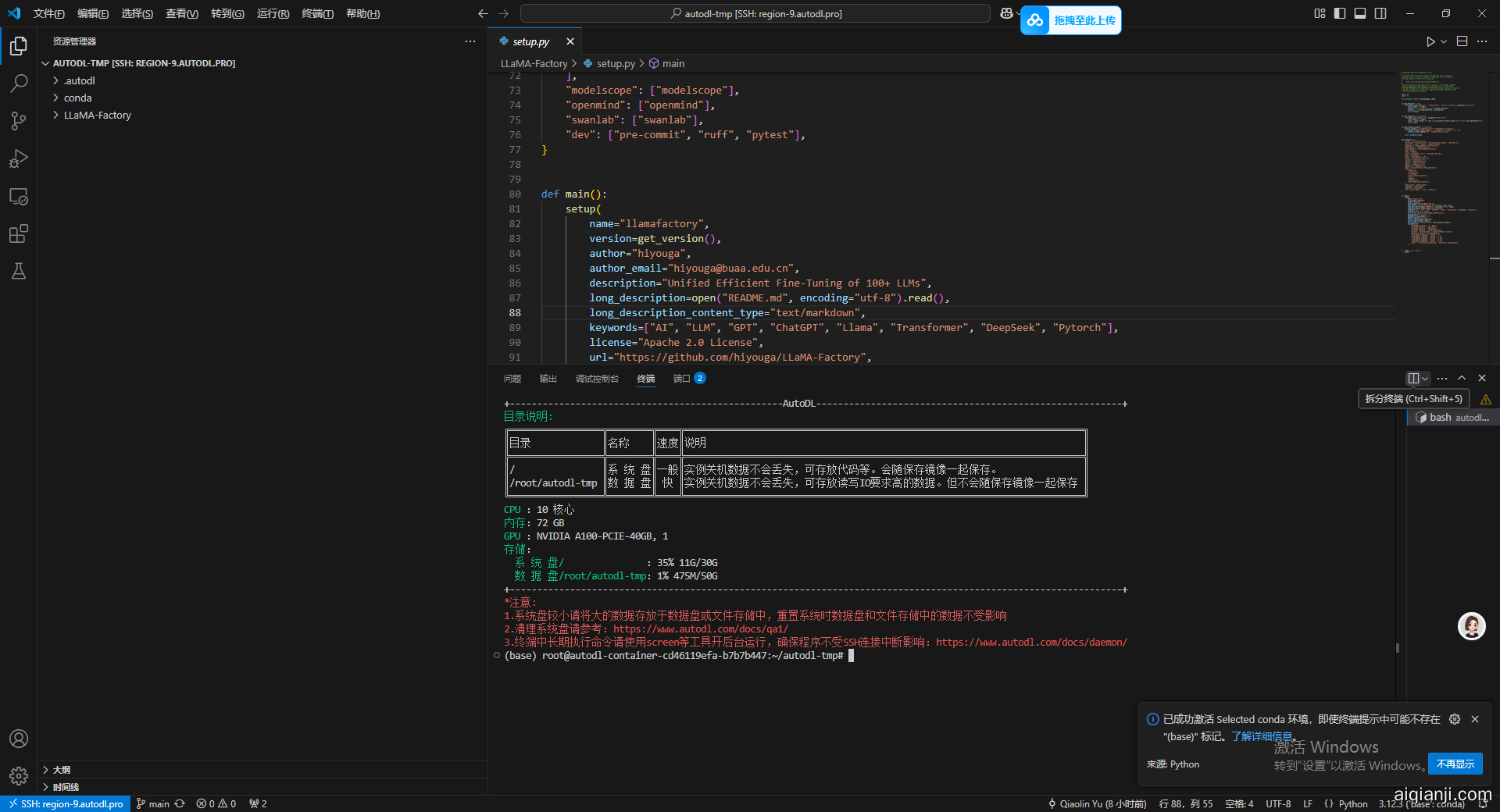

9.下载基座模型

首先,还是新建一个文件夹,之后将基座模型下载到这个文件夹中,新开一个终端,主要操作是点击终端面板右侧的加号,我一截图我发现他图标就变,这个大家可以到时候自己找一下。然后输入以下命令再 autodl-tmp 路径下创新一个新的文件夹。

mkdir Hugging-Face

输入命令之后可以在左侧资源管理器部分看到一个刚出生的 Hugging-Face 文件夹。

进入到 LLaMA-Factory 环境里,后面的配置环境和路径的操作都必须在我们刚建好的虚拟环境中执行才可以才不会报错。

conda activate llama-factory

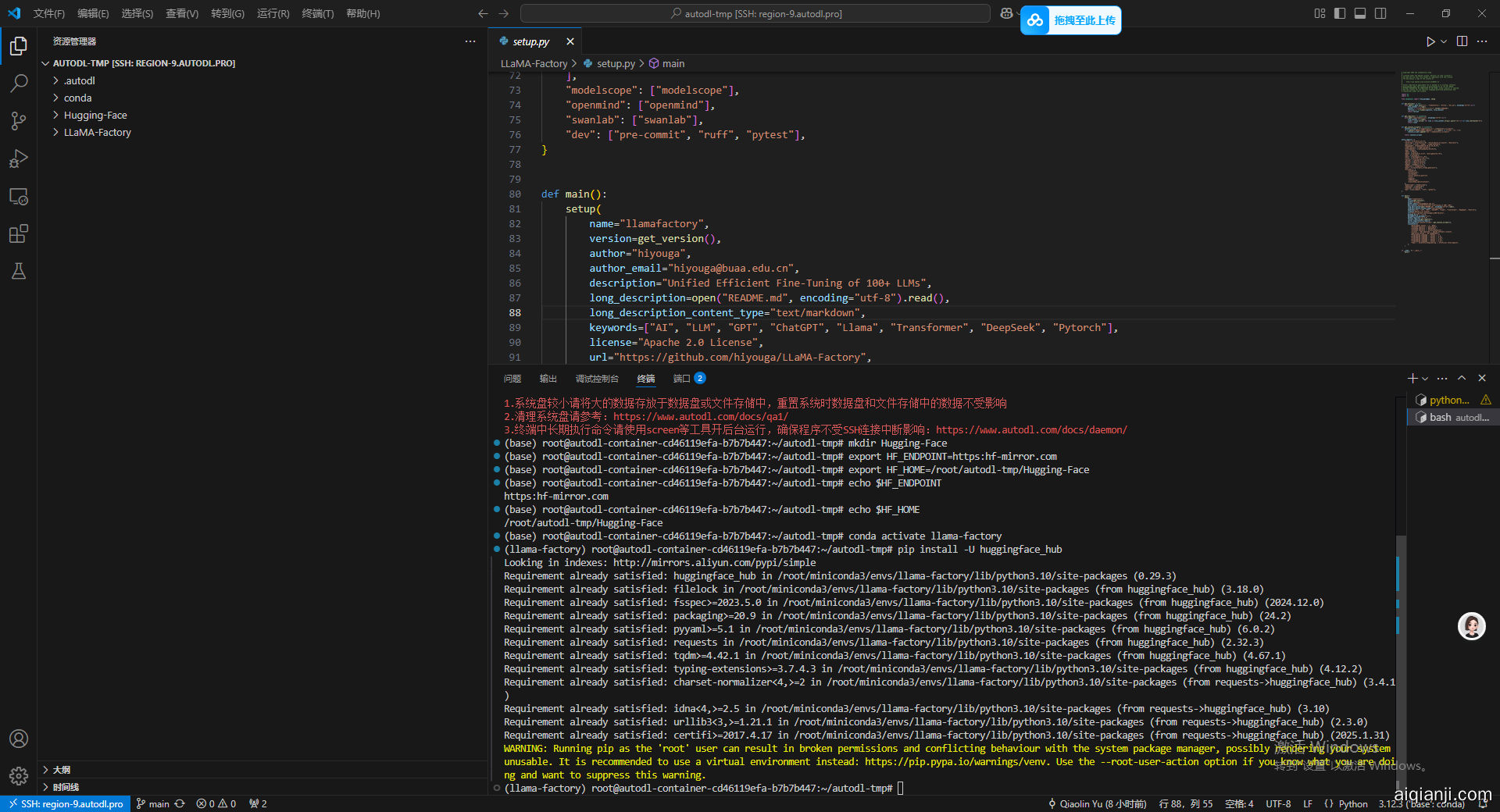

之后修改 HuggingFace 的镜像源,主要是保证使用国内的网络下载的速度。

export HF_ENDPOINT=https:hf-mirror.com

同时修改 HuggingFace 默认的下载路径到我们刚才新建的文件下里面。

export HF_HOME=/root/autodl-tmp/Hugging-Face

最后再使用 echo 命令察看两个关键配置是否生效了。

echo $HF_ENDPOINT

echo $HF_HOME

pip install -U huggingface_hub

接下来就执行下载命令,这里下载的选一个 DeepSeek 蒸馏 通义千问 1.5B 的方便操作。

huggingface-cli download --resume-download deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

HuggingFace:https:huggingface.co