Judea Pearl是一名美国计算机科学家和哲学家,以倡导人工智能的概率方法和贝叶斯网络的发展而闻名。他还因为建立了基于结构模型的因果和反事实推理的理论。他是ACM 图灵奖的2011年度获奖者,这是计算机科学中的最高荣誉,“通过发展概率和因果推理的微积分对人工智能做出了重大贡献”。

Judea Pearl 于1936 年出生于英国的巴勒斯坦,曾在波兰移居父母,1960年从Technion获得电气工程学士学位。1960年移居美国。他于1961 年获得纽瓦克工程学院(现在称为新泽西理工学院)的电气工程硕士学位。然后在罗格斯大学获得物理学硕士学位和博士学位。1965年在纽约大学Tandon工程学院(当时的布鲁克林理工学院)获得电气工程学位。他曾在RCA在超导参数和存储设备上的研究实验室,以及在先进存储器系统上的Electronic Memories公司负责半导体相关的工作,后来他于1970年加入了加州大学洛杉矶分校的工程学院,开始研究概率人工智能。他是“因果推论”(Journal of Causal Inference)的创始编辑之一。

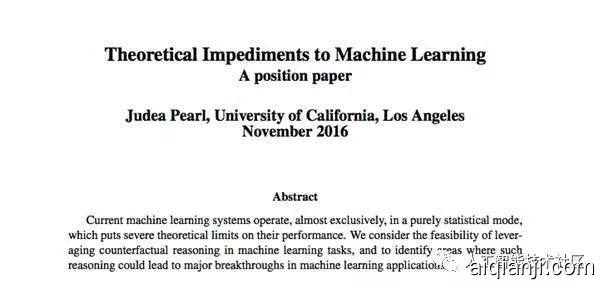

在刚刚过去不久的NIPS 2017现场,就是这位图灵奖得主同时也是贝叶斯之父 Judea Pearl 的报告似乎并没多少人关心。而报告的题目《机器学习的理论障碍》(Theoretical impediments to machine learning)正是关于Judea Pearl对机器学习特别是深度学习背后理论的思考。

CMU大学教授,Petuum公司创始人Eric Xing则在看到这组图后表示:这是NIPS2017大会上一个让人难过的场景。成为一个单纯的“炼金术师”并不可耻,可耻的是并不努力从“炼金术师”学成“化学家”。

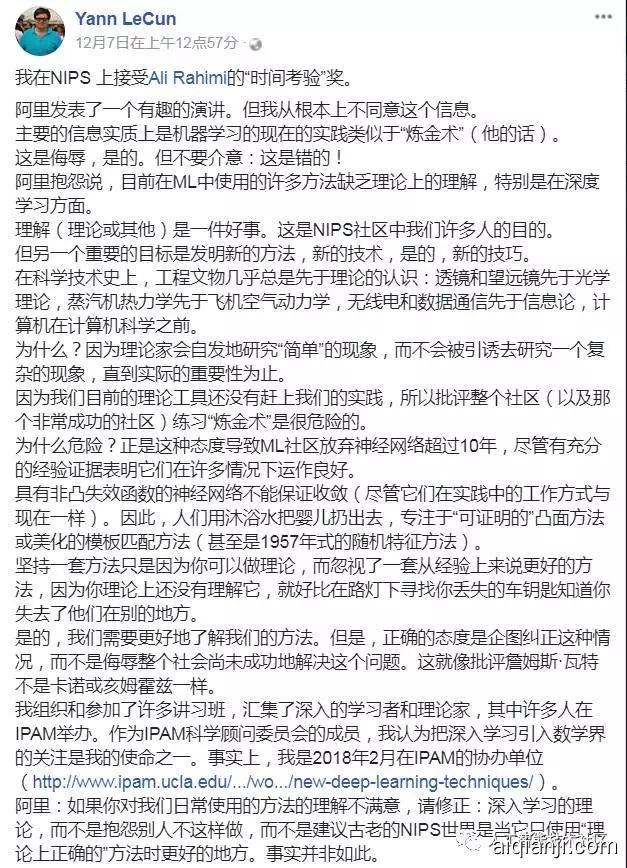

与此同时,NIPS 2017 "Test of Time"论文大奖获得者Ali Rahimi 在长滩现场的演讲中抱怨当前机器学习尤其是深度学习使用的很多方法缺少(理论)理解。

而Lecun则回怼说:仅仅因为理论没有追赶上实践的水平,就批评整个机器学习社区使用「炼金术」,这种言论是危险的。

以下是Ali Rahimi's talk at NIPS(NIPS 2017 Test-of-time award presentation)演讲视频内容

https://v.qq.com/x/page/r05163rm6li.html

AliRahimi与Ali引起的理论之争一石激起千层浪,网络上出现了更多机器学习界的代表发声。

今天芝加哥丰田研究院教授DavidMcAllester发表博文进行解读,以下内容为McAllester的观点:这篇博文的主要受Ali Rahimi最近的NIPS演讲和Lecun回怼的启发。

https://www.reddit.com/r/MachineLearning/comments/7hys85/nalirahimistalkatnipsnips2017testoftime/

https://www.facebook.com/search/str/yann+lecun+alchemy/keywordssearch

机器学习的理论障碍(Theoretical impediments to machine learning):

摘要

目前的机器学习系统几乎完全以纯粹的统计模式运行,这对他们的表现提出了严格的理论限制。我们考虑杠杆化的可行性,在机器学习任务中的反事实推理,并确定这样的领域,推理可能会导致机器学习应用程序的重大突破。

科学背景

如果我们检查今天驱动机器学习的信息,我们发现它几乎是完全的统计。换句话说,学习机器通过优化通过从环境中接收到的感官输入流参数来改善其性能,这是一个缓慢的过程。类似在许多方面适用于进化的适者生存的过程,比如物种老鹰和蛇已经发展了超过百万年的高超的视觉系统。然而它不能解释这个超级进化的过程,因为使得人类能够制造眼镜和望远镜几乎没有一千年。人类拥有其他物种缺乏的精神,人类可以操纵环境的蓝图,可以想象替代假设的规划和学习环境。人类学家,如哈拉里,和米东(S. Mithen)普遍认为给予我们智人的决定性因素大约4万年前,祖先有能力实现全球统治,是他们绘画并存储他们环境表示的能力。询问表示,精神扭曲它想象力的行为,最后回答“假如?”这样的问题。例子是介入问题:“如果我采取行动呢?”和回顾性或解释性问题:“如果我采取行动怎么办?不同?“今天没有学习机器可以回答这样的问题。而且,今天的大多数学习机都不具备使用从哪个可以回答表示这样的问题。

我们假设,实现加速学习速度的主要障碍,以及通过消除这些障碍和装备学习可以克服人类的水平表现带有因果推理工具的机器。这个假设本来是推测二十年在反事实数学的数学化之前。今天不是这样。图形和图形的进步结构模型已经使得反事实计算上易于管理,从而导致了转变。学习值得认真探索。下一节将总结这些进展和解释了如何消除反事实思维的障碍。

三层因果关系

因果推理的逻辑揭示的一个非常有用的见解是存在一个尖锐的因果信息的分类,就每个类别所能提供的问题类型而言的回答。这个分类形成了一个三层次的层次结构,即在第一层次上的问题(i = 1,2,3)只有在j级(j≥i)的信息可用时才能被回答

图1显示了3级层次,以及可以回答的特征问题在每个级别。水平标题为1.协会,2.干预,和3.反事实。选择这些图层的名称来强调它们的用法。我们称之为一级协会,因为它调用纯粹的统计关系,由裸数据定义。例如,观察购买牙膏的顾客更有可能购买牙线;这样的联系可以使用条件期望直接从观测数据中推断出来。问题在这个层,因为他们不需要因果信息,被放置在层次结构的最底层。第二级干预,比协会高,因为它不仅涉及看看是什么,但改变我们所看到的。这个级别的一个典型问题是:会发生什么如果我们加倍价格?这些问题不能单从销售数据来回答,因为它们涉及到客户行为的变化,以适应新的定价。客户选择下的新的价格结构可能与过去普遍存在的差异很大。最后是最高层被称为反事实,这个术语可以追溯到哲学家大卫·休谟(David Hume)和约翰·斯图尔特(John Stewart)Mill,在SCM框架中已经给出了结构语义。一个典型的问题在反事实的类别是“如果我采取不同的行动,那么就需要追溯”推理。

反事实被放置在层次的顶部,因为它们包括介入和联想问题。如果我们有一个可以回答反事实查询的模型,我们也可以回答关于干预和观察的问题。例如,介入性问题,如果我们把价格翻倍,会发生什么?可以通过询问反事实问题来回答:价格是目前价值的两倍会发生什么?同样,关联问题,一旦我们可以回答介入性问题就可以回答;我们简单地忽略了动作部分,并让观察接管。翻译不能在相反的方向上工作。介入问题不能从纯粹的观察信息(即从统计学的角度来回答)数据)。没有涉及回顾的反事实问题可以从纯粹的介入来回答信息,如从受控实验中获得的信息;我们不能重新运行一个对用药物治疗的受试者进行实验,看看他们的行为如何,然后不给予毒品。因此,层次结构是有方向性的,顶层是最强大的层次。最初为计算机视觉开发的深度学习不能直接应用于这些高度不规则的领域,必须设计新的深度学习技术。这是非常具有挑战性的,因为大多数标准数据分析工具不能用于异类数据域。

反事实是科学思维的基石,也是法律和道德的推理。例如,在民事法庭,被告被认为是造成伤害的原因原告如果,但对于被告的行为,伤害不可能有更大的可能性发生。对于比较现实世界和替代的要求的计算意义被告行为没有发生的世界。

层次结构中的每个层都有一个句法签名,用来表征所接受的句子进入该层。例如,关联层以条件概率为特征句子,例如P(y | x)= p,说明:我们观察到事件Y = y的概率事件X = x等于p。在大型系统中,这样的证据句子可以被有效地计算使用贝叶斯网络或任何支持深度学习系统的图形模型。

在介入层,我们找到P(y | do(x),z)类型的句子,它表示“The事件Y = y的概率,因为我们介入并将X的值设置为x,随后观察事件Z = z。这样的表达可以通过随机试验或实验来估计分析使用因果贝叶斯网络(珍珠,2000年,第1章)。

最后,在反事实层面,我们有P(yx | x)类型的表达式(0,y0)站在对于“事件Y = Y的概率X是X,因为我们实际上观察到X是X0和Y是y0。只有当我们拥有功能性或结构性时,才能计算这些句子方程模型,或这些模型的属性。

一种提出的适应性决策的反事实方法

考虑一下这个指令:“你应该采取不同的行动”,在一个代理人的背景下优化行动策略。大多数